在如此快速发展的AI行业中跟上步伐是一项艰巨的任务。所以,在AI能替你做这件事之前,让我们来看看上周机器学习领域的新闻,以及我们没有单独报道的一些值得关注的研究和实验。

上周,Google凭借其在年度I/O开发者大会上发布的一系列新产品,成为AI新闻的主要焦点。这些产品涵盖了各种范围,从与GitHub的Copilot竞争的代码生成AI,到将文本提示转化为短歌的AI音乐生成器。

这些工具中的相当一部分看起来是真正的劳动力节省器——这是不仅仅是营销的夸大之词。我对Project Tailwind特别感兴趣,这是一个笔记应用,利用AI技术整理、总结和分析个人Google Docs文件夹中的文件。但它们也暴露出了即使是当今最好的AI技术的局限性和不足。

以PaLM 2为例,这是Google最新的大型语言模型(LLM)。PaLM 2将为Google更新的Bard聊天工具提供动力,这是该公司对OpenAI的ChatGPT的竞争产品,并作为Google新AI功能的基础模型。但是,尽管PaLM 2可以编写代码、电子邮件等,就像其他类似的LLM一样,但它对问题的回应也带有有毒和有偏见的方式。

Google的音乐生成器也在其能完成的事情上有相当的限制。正如我在亲自试用中所写的,我用MusicLM创作的大部分歌曲听起来顶多算得上是及格——最差的情况就像一个四岁的孩子在DAW上肆意挥霍。

有很多关于AI将取代工作的文章——据高盛的一份报告,可能相当于300百万个全职工作。在哈里斯的一项调查中,40%熟悉OpenAI的AI聊天机器人工具ChatGPT的工作者担心它会完全取代他们的工作。

Google的AI并不是终极答案。实际上,该公司在AI竞赛中可能落后了。但无可否认的事实是,Google雇佣了全球一些顶尖的AI研究人员。如果这是他们能做到的最好的,那么这就证明了AI远非一个已经解决的问题。

以下是过去几天值得注意的其他AI新闻头条:

Meta将生成性AI带入广告:Meta本周宣布了一种AI沙盒,供广告商使用,帮助他们为Facebook或Instagram的广告创建替代版本、通过文本提示生成背景和裁剪图像。该公司表示,这些功能目前对部分广告商开放,将于7月份向更多广告商扩大访问权限。

增加的上下文:Anthropic已将其旗舰文本生成AI模型(仍处于预览阶段)Claude的上下文窗口从9,000个令牌扩大到100,000个令牌。上下文窗口指的是模型在生成额外文本之前考虑的文本,而令牌代表原始文本(例如,“fantastic”将被拆分为“fan”、“tas”和“tic”)。从历史上看,甚至到今天,记忆力差一直是限制文本生成AI实用性的障碍。但更大的上下文窗口可能会改变这种情况。

Anthropic大肆宣扬“宪法AI”:更大的上下文窗口并不是Anthropic模型的唯一区别。本周,该公司详细介绍了“宪法AI”,这是其内部的AI训练技术,旨在将由“宪法”定义的“价值观”赋予AI系统。与其他方法相比,Anthropic认为,宪法AI使得系统的行为更易于理解,并根据需要更简单地进行调整。

一个为研究而生的LLM:非营利性的Allen AI研究所(AI2)宣布,计划训练一个以研究为重点的LLM,名为Open Language Model,为大型并不断增长的开源库增添新成员。AI2将Open Language Model,或简称为OLMo,视为一个平台,而不仅仅是一个模型——一个能让研究社区利用AI2创建的每个组件,自己使用或者寻求改进它的平台。

新的AI基金:在其他AI2新闻中,AI2 Incubator,这个非营利性的AI创业基金,正以其以前规模的三倍——3000万美元对比1000万美元——重新启动。自2017年以来,已经有21家公司通过了孵化器,吸引了大约1.6亿美元的进一步投资,至少有一项重大收购:XNOR,一家AI加速和效率公司,后来被苹果以约2亿美元收购。

EU引入生成性AI的规则:在欧洲议会的一系列投票中,议员们本周支持了一系列对该集团草拟的AI立法的修正案,其中包括对所谓的基础模型的要求,这些基础模型支持了OpenAI的ChatGPT等生成性AI技术。这些修正案要求基础模型的提供者在将他们的模型投放市场之前进行安全检查,数据治理措施和风险缓解。

通用翻译器:Google正在测试一项强大的新翻译服务,该服务能够在视频中用新语言重配音,同时也同步配合说话者的嘴唇与他们从未说过的单词。这可能会出于很多原因而非常有用,但该公司坦率地表示了滥用的可能性以及为防止滥用而采取的步骤。

自动解释:常常有人说,像OpenAI的ChatGPT这样的LLM是一个黑盒子,当然,这种说法有一定的道理。为了揭开他们的层次,OpenAI正在开发一种工具,以自动确定LLM的哪些部分对其行为负责。负责这项工作的工程师强调,这仍处于早期阶段,但本周已经可以在GitHub上以开源的形式运行代码。

IBM发布新的AI服务:在其年度Think会议上,IBM宣布了IBM Watsonx,这是一个新平台,提供构建AI模型的工具,并提供访问预训练模型,生成计算机代码,文本等。该公司表示,推动这次发布的动力源于许多企业在工作场所部署AI时仍然面临的挑战。

其他机器学习内容

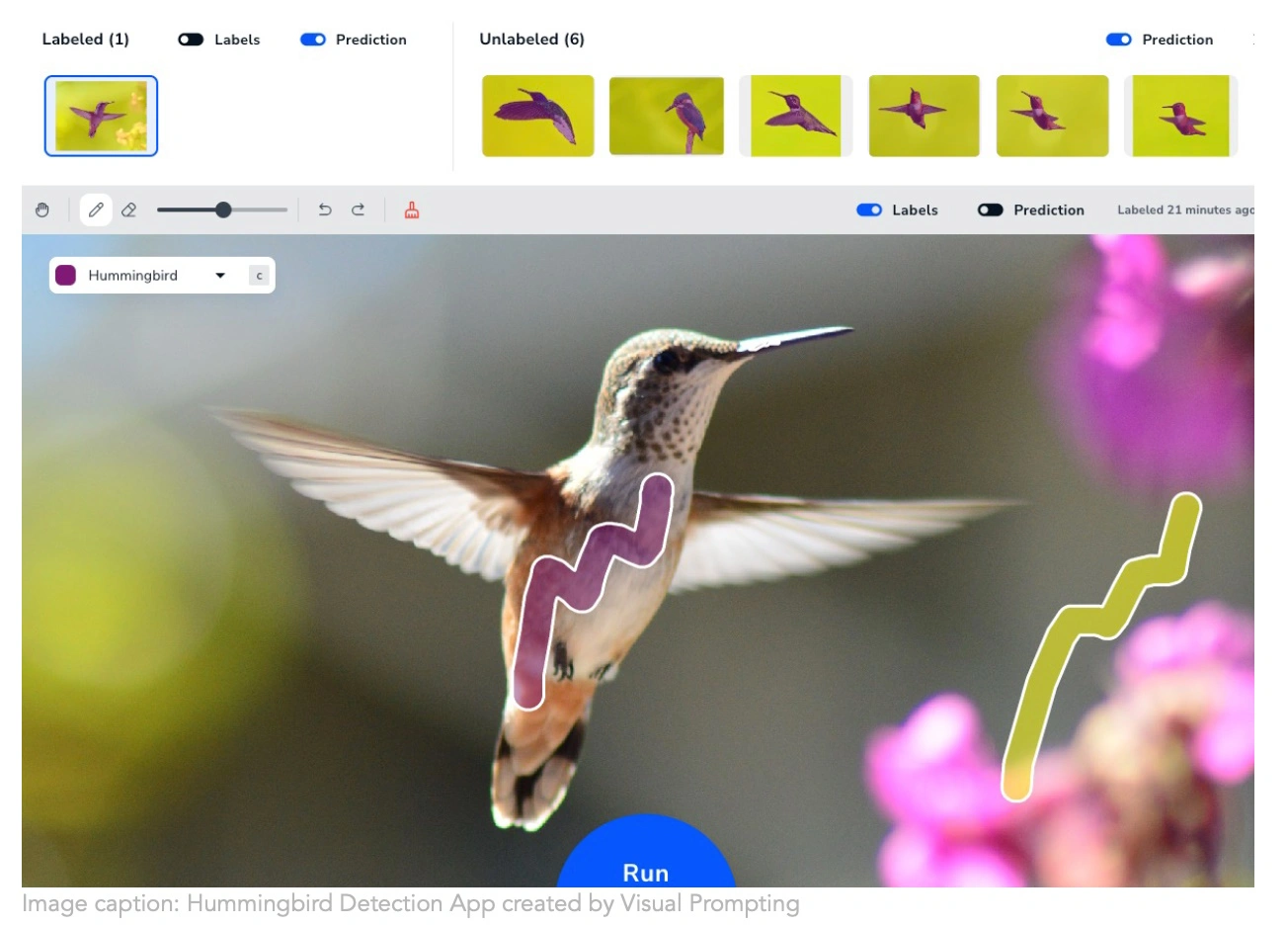

Andrew Ng的新公司Landing AI正在采取一种更直观的方法来创建计算机视觉训练。让一个模型理解你希望在图像中识别什么是非常繁琐的,但他们的“视觉提示”技术让你只需做几笔就能从那里理解你的意图。任何需要构建分割模型的人都会说“我的天,终于有了!”这可能对于那些目前需要花费几个小时对细胞器和家居用品进行遮罩的研究生来说,是个大好消息。

微软已经以一种独特而有趣的方式应用扩散模型,本质上是使用它们来生成一个动作向量,而不是一张图像,这是通过对大量观察到的人类行为进行训练得到的。虽然这个技术还处于非常早期的阶段,扩散并不是这个问题的显而易见的解决方案,但由于它们稳定且多功能,看到它们如何应用于纯视觉任务之外的领域是非常有趣的。他们的论文将在今年晚些时候的ICLR会议上进行介绍。

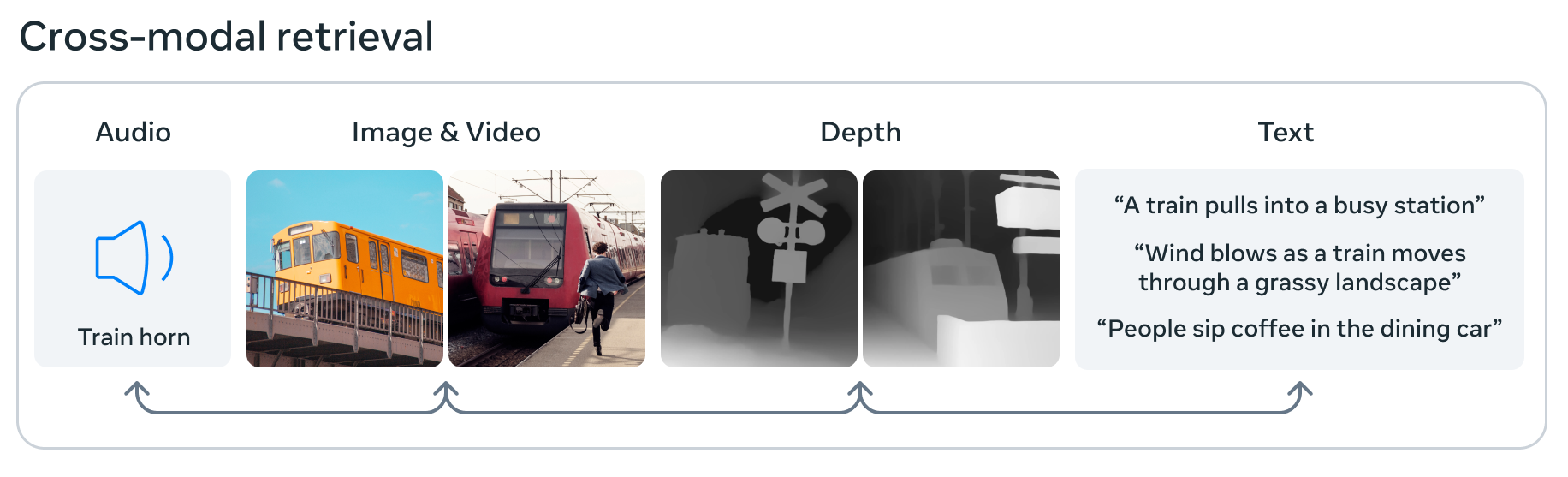

Meta也正在使用ImageBind推动AI的边界,Meta声称这是第一个能够处理和整合来自六种不同模态的数据的模型:图像和视频、音频、3D深度数据、热量信息,以及运动或位置数据。这意味着在其小型机器学习嵌入空间中,一张图像可能会与一个声音、一个3D形状,以及各种文本描述相关联,其中任何一个都可以被询问或用来做出决策。这是向“通用”AI迈出的一步,因为它吸收和关联数据的方式更像大脑,但它仍然是基础的和实验性的,所以现在还不要过分兴奋。

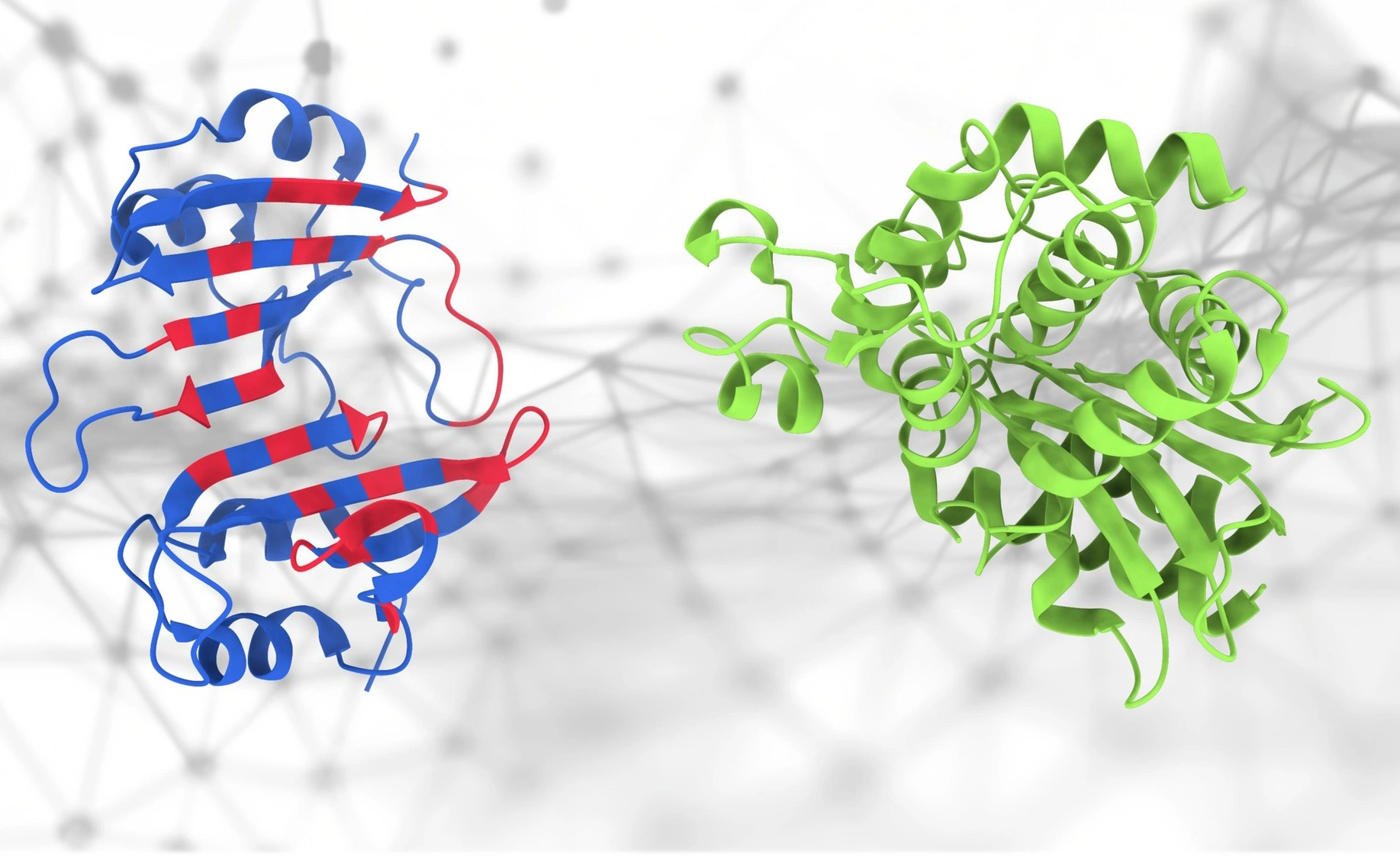

大家都对AlphaFold感到兴奋,这是有充分理由的,但实际上,结构只是蛋白质组学这一非常复杂的科学的一小部分。蛋白质如何相互作用既重要又难以预测,但EPFL的这个新的PeSTo模型试图做到这一点。“它关注蛋白质结构中的重要原子和相互作用,”首席开发者Lucien Krapp说。“这意味着这种方法有效地捕捉了蛋白质结构中的复杂相互作用,以实现对蛋白质结合界面的准确预测。”即使它不是完全准确或100%可靠,不必从头开始对研究人员来说也是非常有用的。