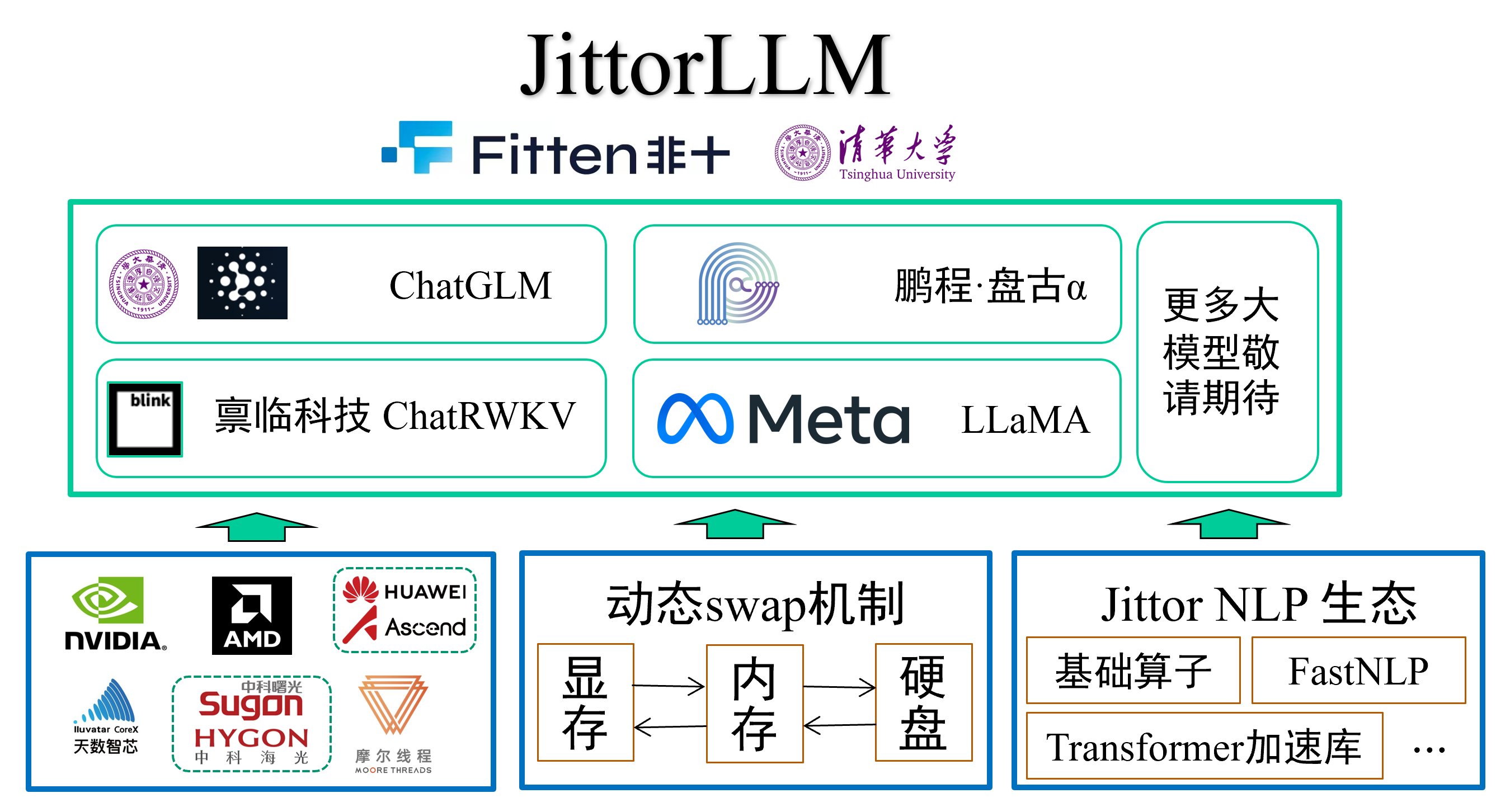

JittorLLMs是一个由Jittor团队开发的大模型推理库,它具有高性能、配置要求低、中文支持好、可移植等特点。以下是对其特性的详细介绍:

- 成本低:相比同类框架,JittorLLMs可以大幅降低硬件配置要求,没有显卡,2G内存就能运行大模型,使得大模型可以在普通机器上本地部署,是目前已知的部署成本最低的大模型库。

- 支持广泛:目前JittorLLMs支持了4种大模型:ChatGLM大模型;鹏程盘古大模型;BlinkDL的ChatRWKV;国外Meta的LLaMA大模型。后续还将支持更多优秀的大模型,统一运行环境配置,降低大模型用户的使用门槛。

- 可移植:用户不需要修改任何代码,只需要安装Jittor版torch(JTorch),即可实现模型的迁移,以便于适配各类异构计算设备和环境。

- 速度快:Jittor框架通过零拷贝技术,大模型加载开销降低40%,同时,通过元算子自动编译优化,计算性能相比同类框架提升20%以上。

- 配置要求低:JittorLLMs只需要2G内存和40GB空闲磁盘空间,无需显卡,也可以部署大模型。在显存充足的情况下,其性能优于同类框架,而在显存不足甚至没有显卡的情况下,JittorLLMs都能以一定速度运行。

- 速度更快:Jittor框架通过内存直通读取,减少内存拷贝数量,大大提升模型加载效率。相比PyTorch框架,Jittor框架的模型加载效率提升了40%。

- 可移植性高:Jittor团队发布Jittor版PyTorch接口JTorch,用户无需修改任何代码,只需要按照如下方法安装,即可通过Jittor框架的优势节省显存、提高效率。

总的来说,JittorLLMs是一个强大的大模型推理库,它可以帮助用户更快、更容易地构建和训练深度学习模型。同时,JittorLLMs也有一个活跃的开发者社区,用户可以在社区中找到大量的教程和示例代码,也可以向社区提问和分享经验。

JittorLLMs的使用也非常简单,只需要通过以下命令安装依赖和部署:

# 国内使用 gitlink clone

git clone https://gitlink.org.cn/jittor/JittorLLMs.git --depth 1

# github: git clone https://github.com/Jittor/JittorLLMs.git --depth 1

cd JittorLLMs

# -i 指定用jittor的源, -I 强制重装Jittor版torch

pip install -r requirements.txt -i https://pypi.jittor.org/simple -I

部署只需一行命令即可:

python cli_demo.py [chatglm|pangualpha|llama|chatrwkv]

运行后会自动从服务器上下载模型文件到本地,会占用根目录下一定的硬盘空间。例如对于盘古α约为 15G。最开始运行的时候会编译一些CUDA算子,这会花费一些时间进行加载。

此外,JittorLLMs还提供了WebDemo,通过gradio库,允许用户在浏览器之中和大模型直接进行对话。只需要运行以下命令:

python web_demo.py chatglm

总的来说,JittorLLMs是一个强大的大模型推理库,它可以帮助用户更快、更容易地构建和训练深度学习模型。同时,JittorLLMs也有一个活跃的开发者社区,用户可以在社区中找到大量的教程和示例代码,也可以向社区提问和分享经验。

主题授权提示:请在后台主题设置-主题授权-激活主题的正版授权,授权购买:RiTheme官网

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。